jueves, noviembre 18, 2010

Obsesión de físicos: científicos atraparon la antimateria

lunes, noviembre 15, 2010

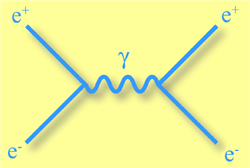

Gravedad y QED

La introducción de la gravedad hace que se puedan realizar ciertos cálculos en electrodinámica cuántica y nos proporciona pistas sobre unificación y gravedad cuántica.

|

Copyleft: atribuir con enlace a http://neofronteras.com/?p=3295

domingo, noviembre 14, 2010

Burbujas gigantes de energía en la Vía Láctea

Dos burbujas de energía captadas por el telescopio Fermi en la Vía Láctea. | Nasa - Nasa Agencia

"Lo que vemos son dos burbujas que emiten rayos gamma y que se extienden a lo largo de 25.000 años luz cada una, de norte y sur, en el centro galáctico", dice el astrónomo Doug Finkbeiner, del centro Smithsonian (Universidad de Harvard). Finkbeiner reconoce que aún no se entiende bien el origen y la naturaleza de este fenómeno de tan grandes dimensiones.

La estructura atraviesa más de la mitad del cielo visible, desde la constelación de Virgo a la de Grus y puede tener millones de años.

Realizando varias estimaciones de esta niebla, Finkbeiner y sus colegas lograron aislar los datos y revelar las burbujas gigantescas. Los científicos tratan ahora de entender cómo se formaron sus estructuras, que parecen tener bordes muy definidos.

domingo, noviembre 07, 2010

Científico holandés postula que la gravedad sería una ilusión

Desde hace mucho tiempo, los físicos saben que la gravedad es una ley física muy extraña. La gravedad no parece relacionarse bien con otras fuerzas básicas de interacción, como las fuerzas electromagnéticas o nucleares. Un científico holandés afirma conocer la razón que explicaría esta particularidad: la gravedad no sería una fuerza fundamental de interacción, sino que derivaría de otra más fundamental de mayor potencia.

El Dr. Eric Verlinde, de 48 años, respetado físico teórico en teoría de cuerdas y profesor de física en el Instituto de Física Teórica de la Universidad de Amsterdam, propuso una nueva teoría de la gravedad, según informó el 12 de julio pasado el periódico New York Times. En el reciente informe titulado "Sobre el origen de la gravedad y las Leyes de Newton”, argumenta que la gravedad es una consecuencia de las leyes de la termodinámica. Yendo contra la lógica de más de 300 años de ciencia, él propone que la gravedad es una ilusión que ha causado confusión continua entre los físicos, o por lo menos entre aquellos que profesan entenderlo.

En su informe afirma: “Para mí, la gravedad no existe”. Eso no significa que el Dr. Verlinde no se caiga por no estar sujeto a las leyes de la gravedad, pero junto con otros físicos, piensa que la ciencia ha estado viendo la gravedad de una manera equivocada y que hay algo más básico de lo cual la gravedad “surge”; del mismo modo en que los mercados de valores surgen debido al comportamiento colectivo de inversionistas individuales o cómo la elasticidad surge de la mecánica entre los átomos.

En el núcleo de su teoría la falta de orden en los sistemas físicos juega un papel relevante. Su argumento se basa en el comportamiento del universo. Para explicarlo con un ejemplo recurre a lo que se podría llamar “un día de cabello rebelde” en la teoría de la gravedad. Dice así: si su cabello se riza con el calor y la humedad es porque también existen muchos otros modos para que el pelo que está rizado se haga lacio, a la naturaleza le gustan las opciones. Entonces, lo que se necesita para alizar el cabello es una fuerza que tire del pelo haciéndolo lacio eliminando las otras opciones de la naturaleza. Olvídese del espacio curvo o la espeluznante atracción a distancia descrita por las ecuaciones de Isaac Newton. El Dr. Verlinde postula que la fuerza que llamamos gravedad es simplemente un subproducto de la propensión de la naturaleza a máximizar el desorden.

La teoría del profesor Verlinde postula que la gravedad es esencialmente una fuerza entrópica. Un objeto moviéndose alrededor de otros objetos pequeños cambiaría el desorden que los rodea y la gravedad se haría sentir. Basado en esta idea de la teoría holográfica, él afirma que puede derivar la segunda ley de la mecánica de Newton. Además, su teoría sobre la física de la masa inercial presenta un nuevo enfoque al viejo concepto.

La investigación sobre el universo en la ciencia moderna esta esencialmente basada en la teoría de la gravedad. Si la gravedad no existiera, entonces nuestra comprensión de las galaxias y la estructura del universo podrían estar equivocadas. Esto puede ser la causa por la que los astrónomos a menudo encuentran difícil explicar el movimiento gravitacional de los cuerpos celestes distantes y tienen que introducir conceptos extraños ad hoc como el de “materia oscura” para ayudar a equilibrar las ecuaciones.

Una nueva teoría de la gravedad podría arrojar luz sobre algunas de las desconcertantes cuestiones cósmicas con las cuales los físicos se encuentran, como la energía oscura, una especie de antigravedad que parece estar acelerando la expansión del universo, o que la materia oscura es supuestamente necesaria para mantener unidas a las galaxias.

“Hemos sabido durante mucho tiempo que la gravedad no existe”, dice el Dr. Verlinde, “Ahora es el momento de gritarlo en voz alta”.