Stephen Hawking

Artículo original en inglés

Traductores : José Luis Acuña / Ariadna Martínez

Esta conferencia versa sobre si podemos predecir el futuro o bien éste es arbitrario y aleatorio. En la antigüedad, el mundo debía de haber parecido bastante arbitrario. Desastres como las inundaciones o las enfermedades debían de haber parecido producirse sin aviso o razón aparente. La gente primitiva atribuía esos fenómenos naturales a un panteón de dioses y diosas que se comportaban de una forma caprichosa e impulsiva. No había forma de predecir lo que harían, y la única esperanza era ganarse su favor mediante regalos o conductas. Mucha gente todavía suscribe parcialmente esta creencia, y tratan de firmar un pacto con la fortuna. Se ofrecen para hacer ciertas cosas a cambio de un sobresaliente en una asignatura, o de aprobar el examen de conducir.

Sin embargo, la gente se debió de dar cuenta gradualmente de ciertas regularidades en el comportamiento de la naturaleza. Estas regularidades eran más obvias en el movimiento de los cuerpos celestes a través del firmamento. Por eso la Astronomía fue la primera ciencia en desarrollarse. Fue puesta sobre una firme base matemática por Newton hace más de 300 años, y todavía usamos su teoría de la gravedad para predecir el movimiento de casi todos los cuerpos celestes. Siguiendo el ejemplo de la Astronomía, se encontró que otros fenómenos naturales también obedecían leyes científicas definidas. Esto llevó a la idea del determinismo científico, que parece haber sido expresada públicamente por primera vez por el científico francés Laplace. Me pareció que me gustaría citar literalmente las palabras de Laplace. y le pedí a un amigo que me las buscara. Por supuesto que están en francés, aunque no esperaba que la audiencia tuviera ningún problema con esto. El problema es que Laplace, como Prewst [N. del T.: Hawking probablemente se refiere a Proust], escribía frases de una longitud y complejidad exageradas. Por eso he decidido parafrasear la cita. En efecto, lo que él dijo era que, si en un instante determinado conociéramos las posiciones y velocidades de todas las partículas en el Universo, podríamos calcular su comportamiento en cualquier otro momento del pasado o del futuro. Hay una historia probablemente apócrifa según la cual Napoleón le preguntó a Laplace sobre el lugar de Dios en este sistema, a lo que él replicó "Caballero, yo no he necesitado esa hipótesis". No creo que Laplace estuviera reclamando que Dios no existe. Es simplemente que El no interviene para romper las leyes de la Ciencia. Esa debe ser la postura de todo científico. Una ley científica no lo es si solo se cumple cuando algún ser sobrenatural lo permite y no interviene.

La idea de que el estado del universo en un instante dado determina el estado en cualquier otro momento ha sido uno de los dogmas centrales de la ciencia desde los tiempos de Laplace. Eso implica que podemos predecir el futuro, al menos en principio. Sin embargo, en la práctica nuestra capacidad para predecir el futuro está severamente limitada por la complejidad de las ecuaciones, y por el hecho de que a menudo exhiben una propiedad denominada caos. Como sabrán bien todos los que han visto Parque Jurásico, esto significa que una pequeña perturbación en un lugar puede producir un gran cambio en otro. Una mariposa que bate sus alas puede hacer que llueva en Central Park, Nueva York. El problema es que eso no se puede repetir. La siguiente vez que una mariposa bata sus alas, una multitud de otras cosas serán diferentes, lo que también tendrá influencia sobre la meteorología. Por eso las predicciones meteorológicas son tan poco fiables.

A pesar de estas dificultades prácticas, el determinismo científico permaneció como dogma durante el siglo 19. Sin embargo, en el siglo 20 ha habido dos desarrollos que muestran que la visión de Laplace sobre una predicción completa del futuro no puede ser llevada a cabo. El primero de esos desarrollos es lo que se denomina mecánica cuántica. Fue propuesta por primera vez en 1900, por el físico alemán Max Planck, como hipótesis ad hoc para resolver una paradoja destacada. De acuerdo con las ideas clásicas del siglo 19, que se remontan a los tiempos de Laplace, un cuerpo caliente, como una pieza de metal al rojo, debería emitir radiación. Perdería energía en forma de ondas de radio, infrarrojos, luz visible, ultravioleta, rayos x, y rayos gamma, todos a la misma tasa. Esto no sólo significaría que todos moriríamos de cáncer de piel, sino que además todo en el universo estaría a la misma temperatura, lo que claramente no es así. Sin embargo, Planck mostró que se puede evitar este desastre si se abandonara la idea de que la cantidad de radiación puede tener cualquier valor, y se dijera en su lugar que la radiación llega únicamente en paquetes o cuantos de un cierto tamaño. Es un poco como decir que en el supermercado no se puede comprar azúcar a granel, sino sólo en bolsas de un kilo. La energía en los paquetes o cuantos es mayor para los rayos x y ultravioleta, que para la luz infrarroja o visible. Esto significa que a menos que un cuerpo esté muy caliente, como el Sol, no tendrá suficiente energía para producir ni siquiera un único cuanto de rayos x o ultravioleta. Por eso no nos quemamos por insolación con una taza de café.

Para Planck los cuantos no eran más que un truco matemático que no tenía una realidad física, lo que quiera que eso signifique. Sin embargo, los físicos empezaron a encontrar otro comportamiento, que sólo podía ser explicado en términos de cantidades con valores discretos o cuantizados, más que variables continuas. Por ejemplo, se encontró que las partículas elementales se comportaban más bien como pequeñas peonzas girando sobre un eje. Pero la cantidad de giro no podía tener cualquier valor. Tenía que ser algún múltiplo de una unidad básica. Debido a que esa unidad es muy pequeña, uno no se da cuenta de que una peonza normal decelera mediante una rápida secuencia de pequeños pasos, más que mediante un proceso continuo. Pero para peonzas tan pequeñas como los átomos, la naturaleza discreta del giro es muy importante.

Pasó algún tiempo antes de que la gente se diera cuenta de las implicaciones que tenía este comportamiento cuántico para el determinismo. No sería hasta 1926, cuando Werner Heisenberg, otro físico alemán, indicó que no podrías medir exactamente la posición y la velocidad de una partícula a la vez. Para ver dónde está una partícula hay que iluminarla. Pero de acuerdo con el trabajo de Planck, uno no puede usar una cantidad de luz arbitrariamente pequeña. Uno tiene que usar al menos un cuanto. Esto perturbará la partícula, y cambiará su velocidad de una forma que no puede ser predicha. Para medir la posición de la partícula con exactitud, deberás usar luz de una longitud de onda muy corta, como la ultravioleta, rayos x o rayos gamma. Pero nuevamente, por el trabajo de Planck, los cuantos de esas formas de luz tienen energías más altas que las de la luz visible. Por eso perturbarán aún más la velocidad de la partícula. Es un callejón sin salida: cuanto más exactamente quieres medir la posición de la partícula, con menos exactitud puedes conocer la velocidad, y viceversa. Esto queda resumido en el Principio de Incertidumbre formulado por Heisenberg; la incertidumbre en la posición de una partícula, multiplicada por la incertidumbre en su velocidad, es siempre mayor que una cantidad llamada la constante de Planck, dividida por la masa de la partícula.

La visión de Laplace del determinismo científico implicaba conocer las posiciones y velocidades de las partículas en el universo en un instante dado del tiempo. Por lo tanto, fue seriamente socavado por el Principio de Incertidumbre de Heisenberg. ¿Cómo puede uno predecir el futuro, cuando uno no puede medir exactamente las posiciones ni las velocidades de las partículas en el instante actual? No importa lo potente que sea el ordenador de que dispongas, si lo alimentas con datos deplorables, obtendrás predicciones deplorables.

Einstein estaba muy descontento por esta aparente aleatoriedad en la naturaleza. Su opinión se resumía en su famosa frase 'Dios no juega a los dados'. Parecía que había presentido que la incertidumbre era sólo provisional, y que existía una realidad subyacente en la que las partículas tendrían posiciones y velocidades bien definidas y se comportarían de acuerdo con leyes deterministas, en consonancia con Laplace. Esta realidad podría ser conocida por Dios, pero la naturaleza cuántica de la luz nos impediría verla, excepto tenuemente a través de un cristal.

La visión de Einstein era lo que ahora se llamaría una teoría de variable oculta. Las teorías de variable oculta podrían parecer ser la forma más obvia de incorporar el Principio de Incertidumbre en la física. Forman la base de la imagen mental del universo, sostenida por muchos científicos, y prácticamente por todos los filósofos de la ciencia. Pero esas teorías de variable oculta están equivocadas. El físico británico John Bell, que murió recientemente, ideó una comprobación experimental que distinguiría teorías de variable oculta. Cuando el experimento se llevaba a cabo cuidadosamente, los resultados eran inconsistentes con las variables ocultas. Por lo tanto parece que incluso Dios está limitado por el Principio de Incertidumbre y no puede conocer la posición y la velocidad de una partícula al mismo tiempo. O sea que Dios juega a los dados con el universo. Toda la evidencia lo señala como un jugador empedernido, que tira los dados siempre que tiene ocasión.

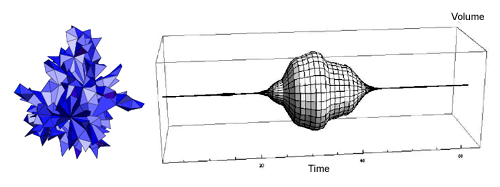

Otros científicos estaban mucho más dispuestos que Einstein a modificar la visión clásica del determinismo del siglo 19. Una nueva teoría, denominada la mecánica cuántica, fue propuesta por Heisenberg, el austríaco Erwin Schroedinger, y el físico británico Paul Dirac. Dirac fue mi penúltimo predecesor en la cátedra Lucasiana de Cambridge. Aunque la mecánica cuántica ha estado entre nosotros durante cerca de 70 años, todavía no es generalmente entendida o apreciada, incluso por aquellos que la usan para hacer cálculos. Sin embargo, debería preocuparnos a todos, puesto que es una imagen completamente diferente del universo físico y de la misma realidad. En la mecánica cuántica, las partículas no tienen posiciones ni velocidades bien definidas. En su lugar, son representadas por lo que se llama una función de onda. Esta es un número en cada punto del espacio. El tamaño de la función de onda indica la probabilidad de que la partícula sea encontrada en esa posición. La tasa con la que la función de onda cambia de punto a punto, proporciona la velocidad de la partícula. Uno puede tener una función de onda con un gran pico en una región muy pequeña. Esto significará que la incertidumbre en la posición es muy pequeña. Pero la función de onda variará muy rápidamente cerca del pico, hacia arriba en un lado, hacia abajo en el otro. Por lo tanto la incertidumbre en la velocidad será grande. De la misma manera, uno puede tener funciones de onda en las que la incertidumbre en la velocidad es pequeña, pero la incertidumbre en la posición es grande.

La función de onda contiene todo lo que uno puede saber de la partícula, tanto su posición como su velocidad. Si sabes la función de onda en un momento dado, entonces sus valores en otros momentos son determinados por lo que se llama la ecuación de Schroedinger. Por lo tanto uno tiene aún un cierto determinismo, pero no del tipo que Laplace imaginaba. En lugar de ser capaces de predecir las posiciones y las velocidades de las partículas, todo lo que podemos predecir es la función de onda. Esto significa que podemos predecir sólo la mitad de lo que podríamos de acuerdo con la visión clásica del siglo 19.

Aunque la mecánica cuántica lleva a la incertidumbre cuando tratamos de predecir la posición y la velocidad a un mismo tiempo, todavía nos permite predecir con certidumbre una combinación de posición y velocidad. Sin embargo, incluso este grado de certidumbre parece estar amenazado por desarrollos más recientes. El problema surge porque la gravedad puede torcer el espacio-tiempo tanto que puede haber regiones que no observamos.

Curiosamente, el mismo Laplace escribió un artículo en 1799 sobre cómo algunas estrellas pueden tener un campo gravitatorio tan fuerte que la luz no podría escapar, siendo por tanto arrastrada de vuelta a la estrella. Incluso calculó que una estrella de la misma densidad que el Sol, pero doscientas cincuenta veces más pequeña, tendría esta propiedad. Pero aunque Laplace podría no haberse dado cuenta, la misma idea había sido propuesta 16 años antes por un hombre de Cambridge, John Mitchell, en un artículo en Phylosophical Transactions of the Royal Society. Tanto Mitchel como Laplace concebían a la luz como formada por partículas, más bien como bolas de cañón, que podían ser deceleradas por la gravedad, y hechas caer de vuelta a la estrella. Pero un famoso experimento llevado a cabo por dos americanos, Michelson y Morley, en 1887, mostraron que la luz siempre viajaba a una velocidad de ciento ochenta y seis mil millas por segundo, no importa de dónde viniera. Cómo podía entonces la gravedad decelerarla, y hacerla caer de nuevo.

De acuerdo con las ideas sobre el espacio y el tiempo vigentes en aquel momento esto era imposible. Sin embargo, en 1915 Einstein presentó al mundo su revolucionaria Teoría General de la Relatividad en la cual espacio y tiempo dejaban de ser entidades separadas e independientes. Por el contrario, eran meramente diferentes direcciones de una única noción llamada espacio-tiempo. Esta noción espacio-tiempo no era uniforme sino deformada y curvada debido a su energía inherente. Para que se entienda mejor, imagínese que colocamos un peso (que hará las veces de estrella) sobre una lámina de goma. El peso (estrella) formará una depresión en la goma curvándose la zona alrededor del mismo en contraposición a la planicie anterior. Si hacemos rodar canicas sobre la lámina de goma, sus rastros serán espirales más que líneas rectas. En 1919, una expedición británica en el Oeste de África observaba la luz de estrellas lejanas que cruzaba cerca del sol durante un eclipse. Descubrieron que las imágenes de las estrellas variaban ligeramente de sus posiciones habituales; esto revelaba que las trayectorias de la luz de las estrellas habían sido curvadas por el influjo del espacio-tiempo que rodea al sol. La Relatividad General había sido confirmada.

Imagínese ahora que colocamos pesos sobre la lámina de goma cada vez más cuantiosos y de manera más intensiva. Hundirán la plancha cada vez más. Con el tiempo, alcanzado el peso y la masa crítica se hará un agujero en la lámina por el que podrán caer las partículas pero del que no podrá salir nada.

Según la Teoría General de la Relatividad lo que sucede con el espacio-tiempo es bastante similar. Cuanto más ingente y más densa sea una estrella, tanto más se curvará y distorsionará el espacio-tiempo alrededor de la misma. Si una estrella inmensa que ha consumido ya su energía nuclear se enfría encogiéndose por debajo de su masa crítica, formará literalmente un agujero sin fondo en el espacio-tiempo por el que no puede pasar la luz. El físico americano John Wheeler llamó a estos objetos “agujeros negros” siendo el primero en destacar su importancia y los enigmas que encierran. El término se hizo popular rápidamente. Para los americanos sugería algo oscuro y misterioso mientras que para los británicos existía además la amplia difusión del Agujero Negro de Calcuta. Sin embargo los franceses, muy franceses ellos, percibieron algo indecente en el vocablo. Durante años se resistieron a utilizar el término, demasiado negro, arguyendo que era obsceno; pero era parecido a intentar luchar contra préstamos lingüísticos como “le weekend” y otras mezcolanzas del “franglés”. Al final tuvieron que claudicar. ¿Quién puede resistirse a una expresión así de conquistadora?

Ahora tenemos evidencias de la existencia de agujeros negros en diferentes tipos de entidades, desde sistemas de estrellas binarios al centro de las galaxias. Por lo tanto, la existencia de agujeros negros está ampliamente aceptada hoy en día. Con todo y al margen de su potencial para la ciencia ficción, ¿cuál sería su relevancia para el determinismo? La respuesta reside en una pegatina de parachoques que tenía en la puerta de mi despacho: “los agujeros negros son invisibles”. No sólo ocurre que las partículas y los astronautas desafortunados que caen en un agujero negro no vuelven nunca, sino que la información que estos portan se pierde para siempre, al menos en nuestra demarcación del universo. Puede lanzar al agujero negro aparatos de televisión, sortijas de diamantes e incluso a sus peores enemigos y todo lo que recordará el agujero negro será su masa total y su estado de rotación. John Wheeler llamó a esto “un agujero negro no tiene pelo”. Esto confirma las sospechas de los franceses.

Mientras hubo el convencimiento de que los agujeros negros existirían siempre, esta pérdida de información pareció no importar demasiado. Se podía pensar que la información seguía existiendo dentro de los agujeros negros. Simplemente es que no podemos saber lo que hay desde fuera de ellos pero la situación cambió cuando descubrí que los agujeros negros no son del todo negros. La Mecánica Cuántica hace que estos emitan partículas y radiaciones a un ritmo constante. Estos hallazgos me asombraron no sólo a mí si no al resto del mundo pero con la perspectiva del tiempo esto habría resultado obvio. Lo que se entiende comúnmente como “el vacío” no está realmente vacío ya que está formado por pares de partículas y antipartículas. Estas permanecen juntas en cierto momento del espacio-tiempo, en otro se separan para después volver a unirse y finalmente aniquilarse la una a las otra. Estas partículas y antipartículas existen porque un campo, tal como los campos que transportan la luz y la gravedad no puede valer exactamente cero. Esto denotaría que el valor del campo tendría tanto una posición exacta (en cero) como una velocidad o ritmo de cambio exacto (también cero). Esto violaría el Principio de Incertidumbre porque una partícula no puede tener al tiempo una posición y una velocidad constantes. Por lo tanto, todos los campos deben tener lo que se denomina fluctuaciones del vacío. Debido al comportamiento cuántico de la naturaleza se puede interpretar estas fluctuaciones del vacío como partículas y antipartículas como he descrito anteriormente.

Estos pares de partículas se dan en conjunción con todas las variedades de partículas elementarias. Se denominan partículas virtuales porque se producen incluso en el vacío y no pueden ser mostradas directamente por los detectores de partículas. Sin embargo, los efectos indirectos de las partículas virtuales o fluctuaciones del vacío han sido estudiados en diferentes experimentos, siendo confirmada su existencia.

Si hay un agujero negro cerca, uno de los componentes de un par de partículas y antipartículas podría deslizarse en dicho agujero dejando al otro componente sin compañero. La partícula abandonada puede caerse también en el agujero o bien desplazarse a larga distancia del mismo donde se convertirá en una verdadera partícula que podrá ser apreciada por un detector de partículas. A alguien muy alejado del agujero negro le parecerá que la partícula ha sido emitida por el mismo agujero.

Esta explicación de cómo los agujeros negros no son tan negros clarifica que la emisión dependerá de la magnitud del agujero negro y del ritmo al que esté rotando. Sin embargo, como un agujero negro no tiene pelo, citando a Wheeler, la radiación será por otra parte independiente de lo que se deslizó por el agujero. No importa lo que arroje a un agujero negro: aparatos de televisión, sortijas de diamantes o a sus peores enemigos. Lo que de allí sale es siempre lo mismo.

Pero ¿qué tiene esto que ver con el determinismo que es sobre lo que se supone que versa esta conferencia? Lo que esto demuestra es que hay muchos estados iniciales (incluyendo aparatos de televisión, sortijas de diamantes e incluso gente) que evolucionan hacia el mismo estado final, al menos fuera del agujero negro. Sin embargo, en la visión de Laplace sobre el determinismo había una correspondencia exacta entre los estados iniciales y los finales. Si usted supiera el estado del universo en algún momento del pasado podría predecirlo en el futuro. De manera similar, si lo supiera en el futuro, podría deducir lo que habría sido en el pasado. Con el advenimiento de la Teoría del Cuanto en los años 20 del siglo pasado se redujo a la mitad lo que uno podía predecir pero aún dejó una correspondencia directa entre los estados del universo en diferentes momentos. Si uno supiera la función de onda en un momento dado, podría calcularla en cualquier otro.

Sin embargo, la situación es bastante diferente con los agujeros negros. Uno se encontrará con el mismo estado fuera del agujero, independientemente de lo que haya lanzado dentro, a condición de que tenga la misma masa. Por lo tanto, no hay una correspondencia exacta entre el estado inicial y el estado final ya fuera del agujero negro. Habrá una correspondencia exacta entre el estado inicial y el final ambos fuera o ambos dentro del agujero negro. Sin embargo, lo importante es que la emisión de partículas y la radiación alrededor del agujero provocan una reducción en la masa del mismo y se empequeñece. Finalmente, parece que el agujero negro llega a la masa cero y desaparece del todo. Pero, ¿qué ocurre con todos los objetos que fueron lanzados al agujero y con toda la gente que o bien saltó o fue empujada? No pueden volver a salir porque no existe la suficiente masa o energía sobrante en el agujero negro para enviarlos fuera de nuevo. Puede que pasen a otro universo pero eso nos da lo mismo a los que somos lo suficientemente prudentes como para no saltar dentro de un agujero negro. Incluso la información de lo que cayó dentro del agujero no podría salir de nuevo cuando el agujero desaparezca por último. La información no se distribuye gratuitamente como bien sabrán aquellos de ustedes que paguen facturas telefónicas. La información necesita energía para transportarse, y no habrá suficiente energía de sobra cuando el agujero negro desaparezca.

Lo que todo esto significa es que la información se perderá de nuestra demarcación del universo cuando se formen los agujeros negros para después desvanecerse. Esta pérdida de información implica que podemos predecir incluso menos de lo pensamos, partiendo de la base de la teoría cuántica. En esta teoría puede no ser factible predecir con certidumbre la posición y la velocidad de una partícula al mismo tiempo. Hay sin embargo una combinación de posición y velocidad que sí puede ser predicha. En el caso de un agujero negro, esta predicción específica concierne a los dos miembros de un par de partículas-antipartículas pero únicamente podemos detectar la partícula expulsada. No hay modo alguno, incluso en un principio, de poner de manifiesto la partícula que se precipita al agujero. Por lo tanto, por lo que sabemos, podría estar en cualquier estado. Esto significa que no podemos hacer ninguna predicción concreta acerca de la partícula que expulsa el agujero. Podemos calcular la probabilidad de que la partícula tenga esta o aquella posición o velocidad pero no podemos predecir con precisión una combinación de la posición y velocidad de sólo una partícula porque su velocidad y posición van a depender de la otra partícula, la cual no está bajo nuestra observación. Así que Einstein estaba sin lugar a dudas equivocado cuando dijo, “Dios no juega a los dados”. No sólo Dios juega definitivamente a los dados sino que además a veces los lanza a donde no podemos verlos.

Muchos científicos son como Einstein en el sentido de que tienen un lazo emocional muy fuerte con el determinismo pero al contrario que Einstein han aceptado la reducción en nuestra capacidad para predecir que nos había traído consigo la teoría cuántica. Pero ya era mucho. A estos no les gustó la consiguiente reducción que los agujeros negros parecían implicar. Pensar que el universo es determinista, como creía Laplace, es simplemente inocente. Presiento que estos científicos no se han aprendido la lección de la historia. El universo no se comporta de acuerdo a nuestras preconcebidas ideas. Continúa sorprendiéndonos.

Podría pensarse que no importa demasiado si el determinismo hizo aguas cerca de los agujeros negros. Estamos casi seguros de estar al menos a unos pocos años luz de agujero negro de cualquier tamaño pero según el Principio de Incertidumbre, cada región del espacio debería estar llena de diminutos agujeros negros virtuales que aparecerían y desaparecerían una y otra vez. Uno pensaría que las partículas y la información podrían precipitarse en estos agujeros negros y perderse. Sin embargo, como estos agujeros negros virtuales son tan pequeños (cien billones de billones más pequeños que el núcleo de un átomo) el ritmo al cual se perdería la información sería muy bajo. Esto es por lo que las leyes de la ciencia parecen deterministas, observándolas con detenimiento. Sin embargo, en condiciones extremas, tales como las del universo temprano o las de la colisión de partículas de alta energía, podría haber una significativa pérdida de información. Esto conduce a la imprevisibilidad en la evolución del universo.

En resumen, de lo que he estado hablando es de si el universo evoluciona de manera arbitraria o de si es determinista. La visión clásica propuesta por Laplace estaba fundada en la idea de que el movimiento futuro de las partículas estaba determinado por completo, si su sabían sus posiciones y velocidades en un momento dado. Esta hipótesis tuvo que ser modificada cuando Heisenberg presentó su Principio de Incertidumbre el cual postulaba que no se podía saber al mismo tiempo y con precisión la posición y la velocidad. Sin embargo, sí que era posible predecir una combinación de posición y velocidad pero incluso esta limitada certidumbre desapareció cuando se tuvieron en cuenta los efectos de los agujeros negros: la pérdida de partículas e información dentro de los agujeros negros dio a entender que las partículas que salían eran fortuitas.

Se pueden calcular las probabilidades pero no hacer ninguna predicción en firme. Así, el futuro del universo no está del todo determinado por las leyes de la ciencia, ni su presente, en contra de lo que creía Laplace. Dios todavía se guarda algunos ases en su manga.

Es todo lo que tengo que decir por el momento. Gracias por escucharme.